Voordelen en nadelen van GPU delen

De Wet van Moore is al bijna een halve eeuw relevant. Processorchips blijven meer transistors bevatten en technologieën gaan dagelijks vooruit. Naarmate de technologie zich ontwikkelt, verandert ook onze benadering van computergebruik. De opkomst van bepaalde computertaken heeft de ontwikkeling van hardware aanzienlijk beïnvloed. Apparaten die oorspronkelijk ontworpen waren voor grafische verwerking zijn nu bijvoorbeeld belangrijke, betaalbare hulpmiddelen voor moderne neurale netwerken.

Het beheer van computermiddelen is ook veranderd. Massadiensten gebruiken nu zelden nog mainframes, zoals in de jaren 1970 en 1980. In plaats daarvan geven ze de voorkeur aan clouddiensten of het bouwen van hun eigen infrastructuur. Deze verschuiving heeft de eisen van de klant veranderd, met een focus op snel, on-demand schalen en het maximaliseren van het gebruik van toegewezen computerbronnen.

Virtualisatie- en containerisatietechnologieën zijn als oplossingen naar voren gekomen. Applicaties worden nu verpakt in containers met alle benodigde bibliotheken, wat het uitrollen en schalen vereenvoudigt. Handmatig beheer werd echter onpraktisch toen het aantal containers in de duizenden steeg. Gespecialiseerde orchestrators zoals Kubernetes zorgen nu voor effectief beheer en schaling. Deze tools zijn een essentieel onderdeel geworden van elke moderne IT-infrastructuur.

Servervirtualisatie

Tegelijkertijd ontwikkelden virtualisatietechnologieën zich, waardoor het mogelijk werd om geïsoleerde omgevingen te creëren binnen een enkele fysieke server. Virtuele machines gedragen zich identiek aan gewone fysieke servers, waardoor het gebruik van standaard beheertools mogelijk is. Afhankelijk van de hypervisor wordt vaak een gespecialiseerde API meegeleverd, die het automatiseren van routineprocedures vergemakkelijkt.

Deze flexibiliteit gaat echter gepaard met verminderde beveiliging. Aanvallers hebben hun focus verlegd van het aanvallen van individuele virtuele machines naar het uitbuiten van zwakke plekken in de hypervisor. Door de controle over een hypervisor te krijgen, kunnen aanvallers naar believen toegang krijgen tot alle gekoppelde virtuele machines. Ondanks voortdurende verbeteringen in de beveiliging blijven moderne hypervisors aantrekkelijke doelwitten.

Traditionele virtualisatie pakt twee belangrijke problemen aan. Eerste probleem: het zorgt voor de isolatie van virtuele machines van elkaar. Bare-metal oplossingen omzeilen dit probleem omdat klanten volledige fysieke servers onder hun beheer huren. Maar voor virtuele machines is isolatie softwaregebaseerd op het niveau van de hypervisor. Een fout in de code of een willekeurige bug kan deze isolatie in gevaar brengen, waardoor gegevens kunnen uitlekken of beschadigd raken.

Het tweede probleem betreft resource management. Hoewel het mogelijk is om de toewijzing van resources aan specifieke virtuele machines te garanderen, vormt het beheer van een groot aantal machines een dilemma. Resources kunnen onderbenut raken, wat resulteert in minder virtuele machines per fysieke server. Dit scenario is onrendabel voor de infrastructuur en leidt onvermijdelijk tot prijsverhogingen.

Als alternatief kun je mechanismen voor automatisch resourcebeheer gebruiken. Hoewel een virtuele machine specifieke gedeclareerde karakteristieken krijgt toegewezen, wordt in feite alleen het vereiste minimum geleverd binnen deze limieten. Als de machine meer processortijd of RAM nodig heeft, zal de hypervisor proberen dit te leveren, maar kan dit niet garanderen. Deze situatie is vergelijkbaar met het overboeken van vliegtuigen, waarbij luchtvaartmaatschappijen meer tickets verkopen dan er stoelen beschikbaar zijn.

De logica is identiek. Als statistieken aantonen dat ongeveer 10% van de passagiers niet op tijd komt voor hun vlucht, kunnen luchtvaartmaatschappijen 10% meer tickets verkopen met een minimaal risico. Als alle passagiers komen, zullen sommige passagiers niet aan boord passen. De luchtvaartmaatschappij zal kleine gevolgen ondervinden in de vorm van compensatie, maar zal waarschijnlijk doorgaan met deze praktijk.

Veel infrastructuuraanbieders hanteren een vergelijkbare strategie. Sommigen zijn er transparant over en geven aan dat ze geen constante beschikbaarheid van computermiddelen garanderen, maar wel aanzienlijk lagere prijzen bieden. Anderen gebruiken soortgelijke mechanismen zonder er reclame voor te maken. Ze gokken erop dat niet alle klanten consequent 100% van hun serverresources zullen gebruiken, en zelfs als sommigen dat doen, zullen ze in de minderheid zijn. Ondertussen genereren ongebruikte bronnen winst.

In deze context hebben bare-metal oplossingen een voordeel. Ze garanderen dat toegewezen resources volledig worden beheerd door de klant en niet worden gedeeld met andere gebruikers van de infrastructuurleverancier. Dit elimineert scenario's waarbij een hoge belasting door een gebruiker van een naburige server de prestaties negatief beïnvloedt.

GPU-virtualisatie

Klassieke virtualisatie wordt onvermijdelijk geconfronteerd met de uitdaging van het emuleren van fysieke apparaten. Om de overheadkosten te beperken, zijn er speciale technologieën ontwikkeld waarmee virtuele machines rechtstreeks toegang hebben tot de fysieke apparaten van de server. Deze aanpak werkt in veel gevallen goed, maar wanneer deze wordt toegepast op grafische processors, levert dit direct beperkingen op. Als een server bijvoorbeeld 8 GPU's heeft geïnstalleerd, hebben slechts 8 virtuele machines toegang.

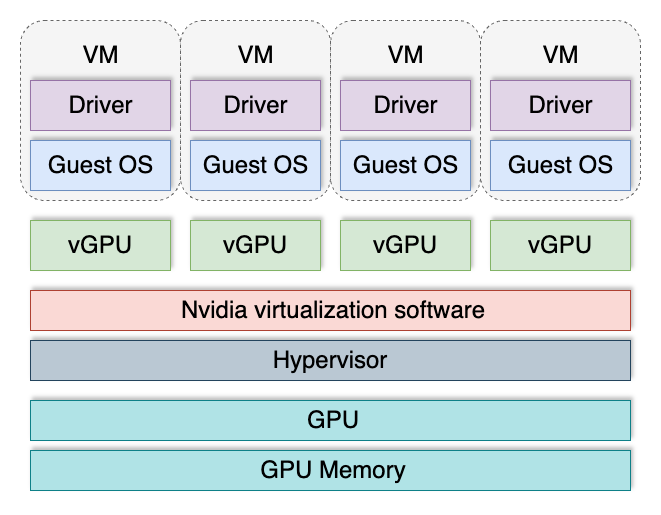

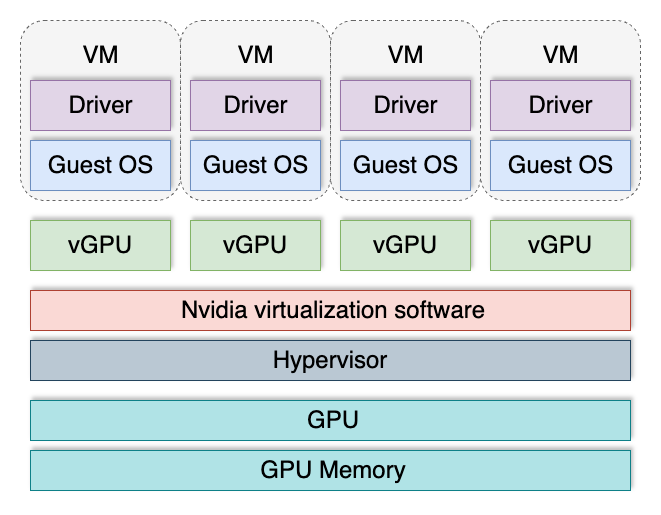

Om deze beperking te omzeilen werd de vGPU-technologie uitgevonden. Deze verdeelt een GPU in meerdere logische GPU's, die vervolgens kunnen worden toegewezen aan virtuele machines. Hierdoor kan elke virtuele machine zijn "stukje taart" krijgen en is hun totale aantal niet langer beperkt door het aantal videokaarten dat in de server is geïnstalleerd.

Virtuele GPU's worden het meest gebruikt bij het bouwen van VDI (Virtual Desktop Infrastructure) in gebieden waar virtuele machines 3D-versnelling nodig hebben. Bij een virtuele werkplek voor een ontwerper of planner gaat het bijvoorbeeld meestal om grafische verwerking. De meeste toepassingen op deze gebieden voeren berekeningen uit op zowel de centrale processor als de GPU. Deze hybride aanpak verhoogt de productiviteit aanzienlijk en zorgt voor een optimaal gebruik van de beschikbare computerbronnen.

Deze technologie heeft echter een aantal nadelen. Het wordt niet ondersteund door alle GPU's en is alleen beschikbaar in het serversegment. De ondersteuning is ook afhankelijk van de geïnstalleerde versie van het besturingssysteem en de GPU-driver. vGPU heeft een apart licentiemechanisme, wat de operationele kosten aanzienlijk verhoogt. Bovendien kunnen de softwarecomponenten mogelijk dienen als aanvalsvector.

Onlangs werd informatie gepubliceerd over acht kwetsbaarheden die alle gebruikers van NVIDIA® GPU's treffen. Zes kwetsbaarheden werden vastgesteld in GPU-stuurprogramma's en twee in de vGPU-software. Deze problemen werden snel verholpen, maar het herinnert ons eraan dat isolatiemechanismen in dergelijke systemen niet feilloos zijn. Constante bewaking en tijdige installatie van updates blijven de belangrijkste manieren om de veiligheid te garanderen.

Bij het bouwen van infrastructuur om vertrouwelijke en gevoelige gebruikersgegevens te verwerken, wordt elke virtualisatie een potentiële risicofactor. In dergelijke gevallen kan een bare-metal aanpak een betere kwaliteit en beveiliging bieden.

Conclusie

Het bouwen van een computerinfrastructuur vereist altijd een risicobeoordeling. Belangrijke vragen om te overwegen zijn onder andere: Zijn klantgegevens veilig beschermd? Creëren de gekozen technologieën extra aanvalsvectoren? Hoe kunnen potentiële kwetsbaarheden worden geïsoleerd en geëlimineerd? Het beantwoorden van deze vragen helpt om weloverwogen keuzes te maken en toekomstige problemen te voorkomen.

Bij LeaderGPU zijn we tot een duidelijke conclusie gekomen: op dit moment is bare-metal technologie superieur in het waarborgen van de veiligheid van gebruikersgegevens, terwijl het dient als een uitstekende basis voor het bouwen van een bare-metal cloud. Deze aanpak stelt onze klanten in staat om flexibiliteit te behouden zonder de extra risico's van GPU-virtualisatie.

Zie ook:

Bijgewerkt: 12.08.2025

Gepubliceerd: 23.01.2025